EU AI規制法とは?日本への影響とやるべき対策とは

AIの開発や活用が進む中、AIの利用に伴うリスクや倫理的な課題も浮き彫りになっています。そんな中、世界に先駆けて包括的なAI規制として成立したのが「EU AI規制法」です。

「ヨーロッパの法律だから、日本には関係ない」と感じるかもしれません。しかし、この法律は、EU市場にサービスを提供したり、EU域内で自社のAIが利用されたりする可能性があるすべての日本企業に直接的な影響を及ぼす可能性があります。

ここでは、EU AI規制法の基本的な概要から、知っておくべき日本への影響、そして今から取り組むべき対策までわかりやすく解説します。

EU AI規制法とは?その目的と施行スケジュール

まずは、EU AI規制法の目的と、いつから何が規制されるのか、全体像を解説します。

目的は「信頼できるAI」の実現とイノベーションの両立

2024年8月1日に「EU AI規制法」が施行(発効)されました

EU AI規制法の最大の目的は、AIが人々の権利や安全を脅かすことのないよう、信頼性を確保することです。人間の尊厳と基本的権利の保護や、透明性と説明責任の確保、安全性とリスク管理などが法的に義務付けられます。

一方で、規制が技術革新の足かせになることを避けるため、研究開発やイノベーションを促進する側面にも配慮されています。ただ規制するだけでなく、安全性と発展性の両立を目指したものと言えるでしょう。

いつから何が規制される?

EU AI規制法の本格的な適用は2026年からですが、規制の内容によって適用時期が異なります。特に重要なスケジュールは以下の通りです。

2025年2月

「許容できないリスク」への法適用開始

2025年8月

GPAI(汎用AI)関連の義務および罰則適用等開始

2026年8月

規制法の大部分が適用開始

このように段階的に施行されるため、事業者は計画的に準備を進める必要があります。

EU AI規制法のリスクレベル分類の基本

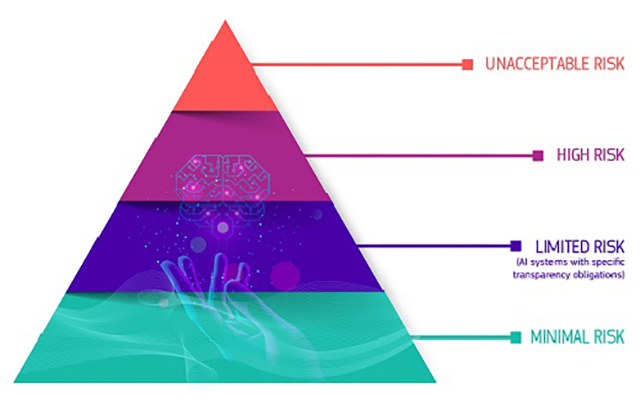

画像出典:AI Act|European Commission

EU AI規制法の中核となるのが「リスクベース・アプローチ」という考え方です。これは、AIがもたらすリスクを4つのレベルに分類して規制を課すもので、すべてのAIが一律に厳しく規制されるわけではありません。

【許容できないリスク】利用禁止

最も厳しい「許容できないリスク(Unacceptable risk)」に分類されるAIは、人々の安全や人権を侵害する危険性が極めて高いと判断されたものです。これらは、原則として利用が禁止されます。

・AIに基づく有害な操作および欺瞞

・AIに基づく脆弱性の有害な悪用

・ソーシャルスコアリング

・個人の犯罪リスクの評価・予測

・顔認証データベースを作成または拡張するための、インターネットやCCTV映像からの無差別なスクレイピング

・職場や教育機関における感情認識

・特定の保護されるべき特性を推測するための生体認証による分類

・公共の場で法執行目的で行われる、リアルタイムの遠隔生体認証(重大犯罪の防止など例外あり)

【高リスク】提供事業者に義務が課せられる

「高リスク(High risk)」に分類されるのは、健康、安全、または基本的権利に深刻なリスクをもたらす可能性のあるAIです。

・重要なインフラ(例:交通機関)におけるAI安全コンポーネントで、市民の生命や健康を危険にさらす可能性のあるもの

・教育機関で使用され、教育へのアクセスや職業人生の進路を決定する可能性のあるAIシステム(例:試験の採点)

・製品のAIベースの安全コンポーネント(例:ロボット支援手術におけるAIアプリケーション)

・雇用、労働者管理、自営業へのアクセスのためのAIツール(例:採用のための履歴書選別ソフトウェア)

・必要不可欠な民間および公共サービスへのアクセスを提供するために利用される特定のAI使用事例(例:市民にローンを取得する機会を拒否する信用スコアリング)

・遠隔生体認証識別や生体認証分類に使用されるAIシステム(例:万引き犯を特定するAIシステム)

・人々の基本的権利を侵害する可能性のある法執行におけるAI使用事例(例:証拠の信頼性評価)

・移民、亡命、国境管理における使用事例(例:ビザ申請の自動審査)

・司法や民主的プロセスで使用されるAIソリューション(例:裁判所の判決準備のためのAIソリューション)

高リスクに分類されるAIを提供する事業者に課される義務

これらのAIを提供する事業者には、以下のような厳格な義務が課せられます。

・適切なリスク評価システム

・差別的な結果のリスクを最小限に抑えるための高品質なデータセット

・結果のトレーサビリティを確保するための活動記録

・システムとその目的に関する必要なすべての情報を当局に提供し、コンプライアンスを評価できるようにする詳細な文書

・導入者への明確で適切な情報提供

・適切な人間による監督措置

・高レベルの堅牢性、サイバーセキュリティ、精度

【限定的リスク】ディープフェイクなど

「限定的リスク(Limited risk)」に分類されるAIには、主に透明性の確保が求められます。ユーザーがAIと対話していることを認識できるようにしたり、AIによって生成されたコンテンツ(ディープフェイクなど)であることを明示したりする義務です。

例えば、Webサイトのカスタマーサポートでチャットボットを使用する場合、「これはAIチャットボットです」といった表示が必要になります。ユーザーが騙されたり、誤解したりすることを防ぐのが目的です。

【最小リスク】世の中の多くのAI

上記3つのいずれにも該当しない、リスクがほとんどないAIは「最小リスク(Minimal or no risk)」とされ、基本的に規制の対象外となります。メールのスパムフィルターや、ビデオゲームに搭載されているAIなど、世の中の多くのAIがここに含まれます。

EU AI規制法の影響と高額な罰金

EU AI規制法が日本のエンジニアにも関係する最大の理由は、その「域外適用」と「高額な罰金」にあります。

域外適用:EU AI規制法は日本企業にも適用される

EU AI規制法には「域外適用」というルールがあります。これは、EU域外の事業者であっても、AIシステムをEUで販売、もしくは、EU域内でサービスが利用可能になる場合などに適用対象となります。

例えば、日本国内のサーバーでAIサービスを提供していても、EU域内のユーザーがそのサービスを利用できる状態であれば適用対象となります。さらに、AIシステムが生成した出力がEU域内で利用される場合も対象となるため、幅広いケースで日本企業が関係します。

違反時の罰則:最大で売上高の7%の罰金

EU AI規制法に違反した場合の罰金は非常に高額です。

最も重い「禁止AI」に関する規制に違反した場合、最大で「3,500万ユーロまたは、全世界年間売上高の7%のいずれか高い方」が科される可能性があります。その他の規定へ違反した場合は「1,500万ユーロまたは全世界年間売上高の3%のいずれか高い方」となり、こちらも高額です。

これらの高額な罰金は、企業経営に深刻なダメージを与えかねないインパクトを持っていると言えるでしょう。

EU AI規制法に向き合う具体的な対策

では、日本のITエンジニアや企業は、EU AI規制法にどう向き合えばよいのでしょうか。具体的な対策を3つのステップで紹介します。

ステップ1: 自社AIの棚卸しとリスク分類

まずは、自社で開発・利用している、あるいは導入を検討しているAIシステムをすべてリストアップする「棚卸し」から始めましょう。その上で、それぞれのAIがEU AI規制法の4つのリスクレベルのどれに該当する可能性があるかを評価・分類します。現状を見落とさずに把握することがすべてのスタートになります。

ステップ2: ギャップ分析とコンプライアンス体制の構築

次に、特に「高リスク」に分類されたAIについて、EU AI規制法が要求する事項と自社の現状のプロセスとの間にどれくらいの差(ギャップ)があるかを分析します。その分析結果に基づいて、法規制を遵守するための社内体制や開発プロセスの見直しを進めます。

ステップ3: 高リスクAIに求められる技術的要件の実装

ギャップ分析で見つかった課題を、実際の開発プロセスに落とし込んでいきます。エンジニアが直接関わる部分として、以下のようなものが挙げられます。

・リスク管理:AIが予期せぬ判断をした場合にリスクを低減させる仕組みの設計

・データガバナンス:学習に使用するデータセットの品質管理、バイアスの最小化

・ログ記録:AIシステムのログを追跡・検証するための自動記録を行う

・人的監視:AIの判断を人間が監督し、必要に応じて介入できる仕組みの確保

・説明可能性:AIの判断根拠を人間が理解できるよう、説明可能な手法を採用する

日本の「AI事業者ガイドライン」との違いと賢い付き合い方

日本でも、総務省と経済産業省が「AI事業者ガイドライン」を公表しています。このガイドラインとEU AI規制法はどのように付き合っていけばよいのでしょうか。

法的拘束力の違い

EU AI規制法と日本の「AI事業者ガイドライン」の最も大きな違いは、法的拘束力の有無です。

EU AI規制法は、違反すれば高額な罰金が科されますが、日本のAI事業者ガイドラインは、事業者が自主的に遵守することが期待されるもので、罰則規定はありません。

ただし、日本のガイドラインも、AIの安全性や公平性、透明性といった原則を掲げており、目指す方向性そのものは、EU AI規制法と多くの点で共通しています。

ガイドライン遵守はグローバル対応への第一歩

日本のAI事業者ガイドラインに沿ってAIの開発・運用を行うことは、結果的にEU AI規制法が求める要件の一部を満たすことにつながります。

特に、日本の著作権法にはAI開発を後押しすると捉えられる規定(第30条の4)があります。しかし、この規定には「著作権者の利益を不当に害することとなる場合には適用されない」というただし書きがあります。

例えば、AIの生成物が学習元の著作物と酷似している場合などは、この例外規定に該当し著作権侵害と判断される可能性があります。グローバル展開を視野に入れるなら、学習データの権利関係には一層の注意が必要です。

まずは国内のガイドラインへの適合からスタートし、グローバルな動向にも目を配りながら、信頼性の高いAI開発を目指すという姿勢が、今後のエンジニアには求められるでしょう。

まとめ

EU AI規制法は、単なる一地域の規制ではなく、AI時代のグローバルスタンダードとなる可能性があります。特に、リスクベースのアプローチや域外適用といった考え方は、今後のAI開発における基本的な「作法」となっていくでしょう。

施行が始まる2026年は、もうすぐそこです。自社が扱うAIのリスクを今のうちから把握し、計画的に準備を進めていくことが不可欠と言えます。

規制を単なる「障壁」と捉えるのではなく、信頼されるAIを開発し、持続可能なイノベーションを実現するための「道しるべ」と捉え、日々の業務に活かしていくスタンスが重要になるでしょう。